Un nuevo sistema de aprendizaje de máquinas desarrollado por el MIT y la Universidad de Boston ofrece un sistema de retroalimentación para que los humanos corrijan los errores del robot utilizando ondas cerebrales.

Ha habido un nuevo avance en la computación controlada por ondas cerebrales. Esta nueva máquina puede reaccionar a los estados del cerebro humano sin necesidad de claves como palabras o colores.

¿Desearía que un robot hiciera lo que quisiera con sólo pensarlo?

Según un artículo publicado el lunes por el Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL) del MIT y la Universidad de Boston, es posible. CSAIL desarrolló un sistema robótico que utiliza la actividad cerebral humana -a través de señales de EEG- para guiar el comportamiento de un robot y corregir sus errores en medio de la tarea.

La mayoría de los robots de hoy en día están programados para seguir órdenes concretas que les permiten realizar tareas específicas. El sistema de CSAIL elimina esta barrera física. La interacción robot/hombre con las señales del EEG permite una comunicación directa y rápida que puede eliminar las barreras para el funcionamiento de un robot.

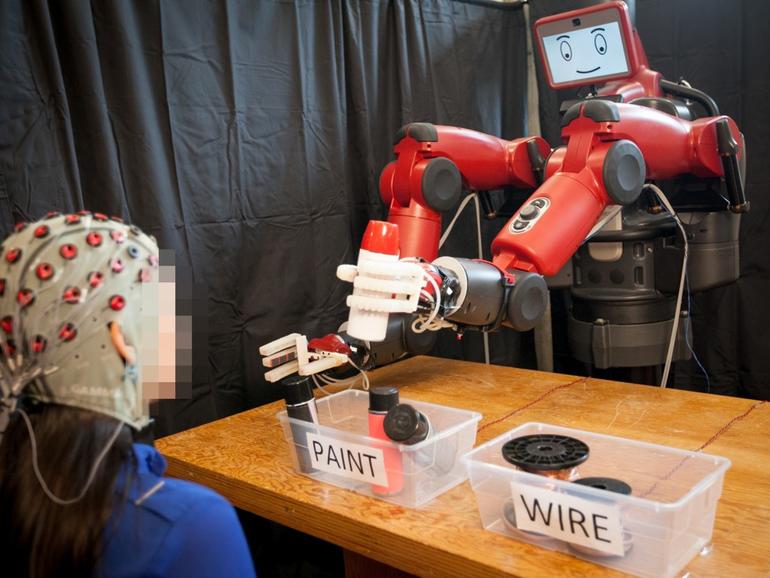

¿Cómo funciona el sistema? El robot aprovecha las señales naturales a medida que se producen en el cerebro humano. En los experimentos, un robot de Rethink Robotics Baxter, un robot «amigo de la gente» con brazos y una cara expresiva de iPad, realizó una sencilla tarea de clasificación de objetos. Basándose en el comando mental del ser humano, el robot recogió uno de los dos tipos de objetos (latas de pintura o alambres) que se colocaban sobre una mesa y los trasladó, uno por uno, al contenedor con la etiqueta apropiada. Véase más adelante:

Es un sistema en tiempo real que monitorea las ondas cerebrales en 10-30 milisegundos. Si el sujeto humano nota que el robot comete un error -Baxter coloca el alambre en el contenedor de pintura, por ejemplo, cuando el comando era para otro contenedor-, el cerebro dispara naturalmente una señal de «potencial relacionado con el error», que es recogida por los algoritmos de aprendizaje de la máquina de Baxter. Cuando Baxter capta la señal, corrige su error a mitad de la tarea. De esta manera, se establece un bucle de retroalimentación entre el ser humano y el robot. Además, se establece un segundo circuito de retroalimentación, en caso de que no se reconociera el primer error, que captaría una señal mental más fuerte.

Entender por qué los robots y los sistemas de IA hacen lo que hacen es una pieza fundamental para establecer la confianza, especialmente con el surgimiento de los «co-bots» o robots colaborativos. Manuela Veloso, directora del departamento de aprendizaje de máquinas de Carnegie Mellon, está trabajando actualmente en el desarrollo de robots que puedan explicar sus acciones verbalmente.

Más información sobre la inteligencia artificial

No es la primera vez que se utilizan señales cerebrales para controlar a los robots. Experimentos anteriores en la operación de robots utilizando ondas cerebrales abordaron el desafío al hacer que un humano realizara una tarea mental específica, como mirar hacia un determinado color que representa la tarea que el robot debería realizar. Pero según la investigadora científica del MIT CSAIL Stephanie Gil, el problema con ese enfoque es que «requiere que los operadores humanos `piensen’ de una manera prescrita que las computadoras puedan reconocer, como mirar una pantalla parpadeante que corresponde a una tarea específica», dijo. «Esta no es una experiencia muy natural para nosotros, y también puede ser mentalmente agotadora, lo que es problemático si nuestro robot está haciendo una tarea peligrosa en la fabricación o la construcción».

El nuevo trabajo de CSAIL, que muestra que los procesos mentales naturales pueden ser utilizados para controlar a los robots, significa que los humanos no tienen que ser»entrenados» de ninguna manera. En cambio, la máquina aprende de los pensamientos humanos naturales.

VER: El sistema MIT AI predice cuándo la gente se besará, abrazará o estrechará la mano (ConsejoTecnologico.com)

¿Qué significa esto? Los resultados del experimento muestran que la retroalimentación basada en el EEG puede ayudar a los humanos a comunicarse con los robots de una manera intuitiva. Aunque la tarea es simple y binaria (con sólo dos opciones para que el robot elija), tiene implicaciones para tareas más complejas en el futuro. Por ejemplo, el equipo dijo que cree que el sistema podría eventualmente ser usado para tareas de opción múltiple. El sistema también podría tener grandes implicaciones para las personas que no pueden comunicarse verbalmente.

Según Gil, este sistema también podría aplicarse potencialmente «en una planta de fabricación donde las tareas más peligrosas puedan ser realizadas por robots bajo la supervisión de un operador humano». También se podría utilizar para operar «un coche autónomo que hace la mayor parte del trabajo mientras es mantenido bajo control por un conductor humano», dijo.

«Imagínese poder decirle instantáneamente a un robot que realice una determinada acción, sin necesidad de escribir un comando, pulsar un botón o incluso decir una palabra», dijo la directora de CSAIL, Daniela Rus, en un comunicado de prensa. «Un enfoque racionalizado como ese mejoraría nuestras habilidades para supervisar robots de fábrica, coches sin conductor y otras tecnologías que aún no hemos inventado.»

Las 3 grandes ventajas para los lectores de ConsejoTecnologico.com

- El Laboratorio de Ciencias de la Computación e Inteligencia Artificial del MIT y la Universidad de Boston se han unido para crear un sistema robótico que puede ser controlado por ondas cerebrales humanas.

- El sistema conecta un robot a un monitor de EEG humano. Si el robot realiza una tarea de forma incorrecta, el sistema capta las señales naturales de «error» humano y el robot corrige su comportamiento.

- El trabajo muestra que el pensamiento humano intuitivo puede controlar el comportamiento de los robots y puede tener grandes implicaciones sobre cómo las personas que no pueden comunicarse verbalmente pueden interactuar con las máquinas.

Próximo boletín informativo de Big Thing

Conoce las ciudades inteligentes, la IA, la Internet de las cosas, la RV, la conducción autónoma, los aviones no tripulados, la robótica y más de las innovaciones tecnológicas más geniales. Entregado los miércoles y viernes

.

…