Soli, la nueva tecnología de gestos de Google, permitiría a los usuarios interactuar con sus dispositivos sin tener que tocar el propio dispositivo. Así es como está listo para causar impacto.

Parece que la cultura pop está obsesionada con la idea de interactuar con la tecnología sin tocar un dispositivo para hacerlo. Películas como Minority Report y Iron Man son los pioneros en esto – la idea de que el futuro de la tecnología será decididamente «sin intervención».

Ese futuro podría llegar antes de lo que pensamos. La semana pasada, en su conferencia anual de desarrolladores de E/S, Google anunció Soli, un proyecto que permitiría a los usuarios interactuar con sus dispositivos mediante gestos manuales realizados cerca del dispositivo, sin necesidad de contacto con el dispositivo.

«El Proyecto Soli es la base técnica de las interacciones humanas con los objetos de vestir, los dispositivos móviles y la Internet de los objetos», dijo un portavoz de Google ATAP (Advanced Technology and Projects.

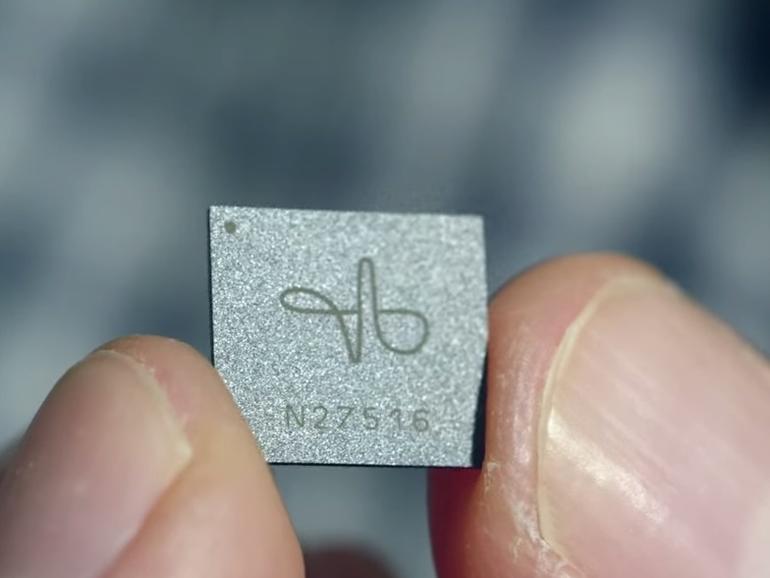

Soli nació del grupo ATAP de Google. Es un chip del tamaño de una uña que utiliza el radar para leer los gestos de las manos y convertirlos en acciones en el dispositivo.

Así que si un usuario tocara su pulgar con el dedo índice, Soli lo leería como un botón que está siendo presionado. O bien, el usuario desliza su dedo índice hacia adelante y hacia atrás en la almohadilla de su pulgar, que podría operar un control deslizante para ajustar el volumen.

A diferencia de las cámaras, que se utilizan en otras tecnologías de detección de movimiento, el radar tiene una alta precisión de posición y, por lo tanto, funciona mejor en este contexto que las cámaras. Es capaz de captar mejor los movimientos leves.

«El radar es una tecnología que transmite una onda de radio hacia un objetivo, y luego el receptor del radar intercepta la energía reflejada de ese objetivo», dijo el ingeniero líder de la investigación Jaime Lien en un video sobre Soli.

Las ondas de radar rebotan en la mano y regresan al receptor, permitiéndole interpretar los cambios en la forma o el movimiento de la mano. El radar también es importante para el proyecto, según el líder del equipo de Soli, Ivan Poupyrev, porque puede trabajar a través de materiales o ser incrustado en objetos.

La tecnología recuerda vagamente al instrumento musical theremin desarrollado en la década de 1920 por Léon Theremin, pero es mucho más intrincado. En el video de Soli, Poupyrev mencionó que la tecnología podría ser utilizada para interactuar con «vestimenta, Internet de las cosas y otros dispositivos informáticos».

El potencial de Soli en prendas de vestir es quizás el caso de uso más obvio hasta ahora. Las pantallas pequeñas dificultan la selección de determinadas aplicaciones o funciones, y la posibilidad de realizar gestos junto al dispositivo puede hacer que la navegación sea más fácil e intuitiva.

Según el analista Ryan Martin, es importante que una empresa como Google se involucre en este espacio porque un proyecto como Soli es importante para los ecosistemas vestibles y de IO en su conjunto y es importante que «se aborde desde una perspectiva tecnológica, no desde una perspectiva de producto».

Hay empresas que se centran únicamente en interacciones basadas en gestos, pero que pueden ser arriesgadas y volátiles, ya que es probable que sólo se integren como una característica. Martin dijo que las prendas para la muñeca son menos eficientes si los usuarios tienen que tocarlas, y Soli podría ser un paso adelante para hacerlas más eficientes y usables.

Otros posibles casos de uso podrían estar dentro de los coches conectados o en los espacios de realidad aumentada (RA) o de realidad virtual (RV. Imagine que su Oculus Rift o Gear VR podría soportar «manos» virtualizadas como otra entrada sin un accesorio de terceros. Aunque, dijo Martin, probablemente funcionaría mejor como un complemento a otro insumo como la voz o el tacto.

El uso de Soli como herramienta de entrada es el caso más evidente por ahora, pero el proyecto también podría aportar valor como tecnología de salida.

«Creo que la aplicación asesina, o caso de uso, a largo plazo va a ser cómo tomar esta tecnología y tenerla escaneando para proporcionar contexto y permitir una automatización que podría ni siquiera necesitar una interacción basada en gestos, simplemente podría suceder», dijo Martin.

Gillette es una de las muchas compañías cuyas fábricas utilizan cámaras de alta velocidad para analizar los procesos de fabricación y los equipos para entender mejor cuándo se necesita mantenimiento o reparación. Soli podría proporcionar un servicio similar a las instalaciones de fabricación avanzada leyendo constantemente las máquinas y documentando su rendimiento.

El tiempo de comercialización dependerá de la experiencia del usuario. Como característica del dispositivo, Soli necesita ser confiable y consistente o será perjudicial para la marca asociada o el OEM que lo integra.

«Una vez que la tecnología sea capaz de cumplir con ese objetivo, creo que será entonces cuando comencemos a ver cómo se convierte en productos, pero ahora mismo está definitivamente en su fase de desarrollo», dijo Martin.

Según el portavoz de Google ATAP, la empresa lanzará próximamente un kit de desarrollo de hardware y software a los desarrolladores. Si desea más información sobre el Proyecto Soli, puede ponerse en contacto con el equipo en projectsoli@google.com.